Ein aktueller Fall zeigt, wie leicht Künstliche Intelligenz (KI) inzwischen zur Manipulation von Beweismitteln eingesetzt werden kann. Eine Londoner Akademikerin, die über Airbnb ein Apartment in Manhattan gemietet hatte, wurde fälschlicherweise beschuldigt, Schäden in Höhe von über 12.000 Pfund verursacht zu haben. Der Gastgeber untermauerte seine Forderungen mit Fotos. Mit weitreichenden Folgen.

Seiteninhalt:

Der Vorfall im Detail

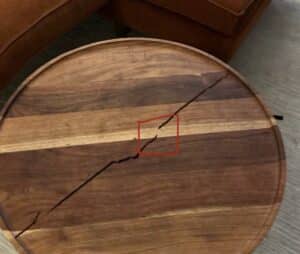

Die Mieterin wies alle Vorwürfe zurück und wies darauf hin, dass die Bilder der beschädigten Möbelstücken Unstimmigkeiten aufwiesen. Nach eigener Analyse zeigten die Fotos klare Hinweise auf digitale Manipulation oder sogar KI-generierte Veränderungen.

Sie legte Widerspruch ein und bot die Aussage eines Zeugen an, der den tadellosen Zustand des Apartments bei Auszug bestätigen konnte.

Airbnb reagiert zunächst nicht

Airbnb akzeptierte zunächst die eingereichten Fotos und forderte die Mieterin auf, mehr als 5.000 Pfund zu zahlen. Erst nach einer umfangreichen Beschwerde und nachdem der Fall öffentlich wurde, entschuldigte sich das Unternehmen und erstattete die volle Summe von 4.269 Pfund. Auch eine negative Bewertung, die der Gastgeber abgegeben hatte, wurde gelöscht.

Airbnb bestätigte, dass die eingereichten Bilder nicht verifiziert werden konnten. Der Gastgeber, ein sogenannter „Superhost“, wurde verwarnt und darauf hingewiesen, dass er bei einem erneuten Vorfall gesperrt werde. Das Unternehmen kündigte zudem eine Überprüfung seiner internen Prozesse an.

Gefahr durch KI-Manipulationen

Experten warnen, dass die Manipulation von Bildern und Videos durch KI inzwischen „leichter denn je“ möglich sei. Laut Serpil Hall, Direktorin für Wirtschaftskriminalität bei Baringa, sei die Software dafür billig, leicht zugänglich und erfordere kaum technisches Wissen. Versicherer hätten bereits eine Zunahme falscher Schadensmeldungen festgestellt, die mit manipulierten Fotos eingereicht wurden. So kann die Bilder KI Sora absolut realistische Fotos erstellen. Sora verändert unsere Welt bereits heute. Im Bereich Versicherungen und Schadensregulierung werden KI generierte Fotos noch zu großen Problemen führen.

In vielen Unternehmen und bei Plattformen wie Airbnb werden Bilder noch immer als primäre Beweisgrundlage genutzt. Die neuen Möglichkeiten der KI-Manipulation stellen diese Praxis jedoch infrage. Bereits heute setzen einige Versicherer auf forensische Tools, um Bildmaterial auf Echtheit zu prüfen.

Was bedeutet dieser Fall für Unternehmen?

Für Unternehmen, die Bildmaterial als Beweis nutzen, bedeutet dieser Vorfall ein erhebliches Risiko. Fotos können ohne großen Aufwand manipuliert werden, wodurch sich Betrüger Vorteile erschleichen können. Firmen müssen daher ihre Prüfverfahren überdenken und auf Technologien zur Erkennung von Bildfälschungen setzen.

Was bedeutet dieser Fall für Versicherer?

Auch Versicherer stehen vor einer großen Herausforderung. Schadensmeldungen mit gefälschten Bildern können zu erheblichen finanziellen Verlusten führen. Zukünftig wird es notwendig sein, KI-gestützte Forensik einzusetzen, um die Authentizität von Beweismaterial zu überprüfen. Standardverfahren reichen nicht mehr aus, um Manipulationen zu erkennen.

Der Airbnb-Fall zeigt deutlich, dass die Verfügbarkeit von KI-Technologien nicht nur Chancen, sondern auch neue Risiken birgt. Wenn Beweise zunehmend manipuliert werden, müssen Unternehmen und Versicherer innovative Lösungen entwickeln, um sich vor Betrug zu schützen. Nur durch den Einsatz moderner Prüfmethoden kann das Vertrauen der Kunden langfristig gewahrt bleiben. Gleichzeitig könnte im Problem auch ein Teil der Lösung liegen. So bieten KI gestützte Geschäftsprozesse die Möglichkeit, Auffälligkeiten rechtzeitig zu entdecken und Gegenmaßnahmen einzuleiten. AirBnb hätte der Skandal so erspart bleiben können.